【SLAI Seminar】第十二期 | 大模型如何突破“推理瓶颈”?

SLAI seminar

11月19日(星期三)上午,华为香港研究所柏昊立博士受深圳河套学院邀请,在B411阶梯教室开展学术报告讲座。本次讲座由姬艳丽教授主持,柏博士以“大模型量化稀疏:挑战、方法与机遇”为题,从工业界亟待解决的推理成本瓶颈切入,深度拆解了参数分布中“异常值”的处理难题。

柏昊立 博士

· 华为香港研究所研究员

· 负责香港基础模型实验室

· NeurIPS 2025 领域主席

· NeurIPS、ICML、ICLR 等会议程序委员会委员

讲座简介

随着大模型日益增长的尺寸与上下文窗口,降低大模型推理成本是工业界关注的核心问题。模型量化与稀疏化是降低模型推理成本的常用手段,然而大模型中存在异常值,精度敏感,难以微调等问题,导致模型压缩存在诸多公开挑战。本次报告回顾了大模型压缩加速的近期代表性工作,如异常值处理,旋转量化,压缩感知训练等热点研究,归纳学界与业界近年研究趋势。最后,报告展望了大模型在慢思考和智能体时代,量化与稀疏研究面临的新机遇。

讲座内容

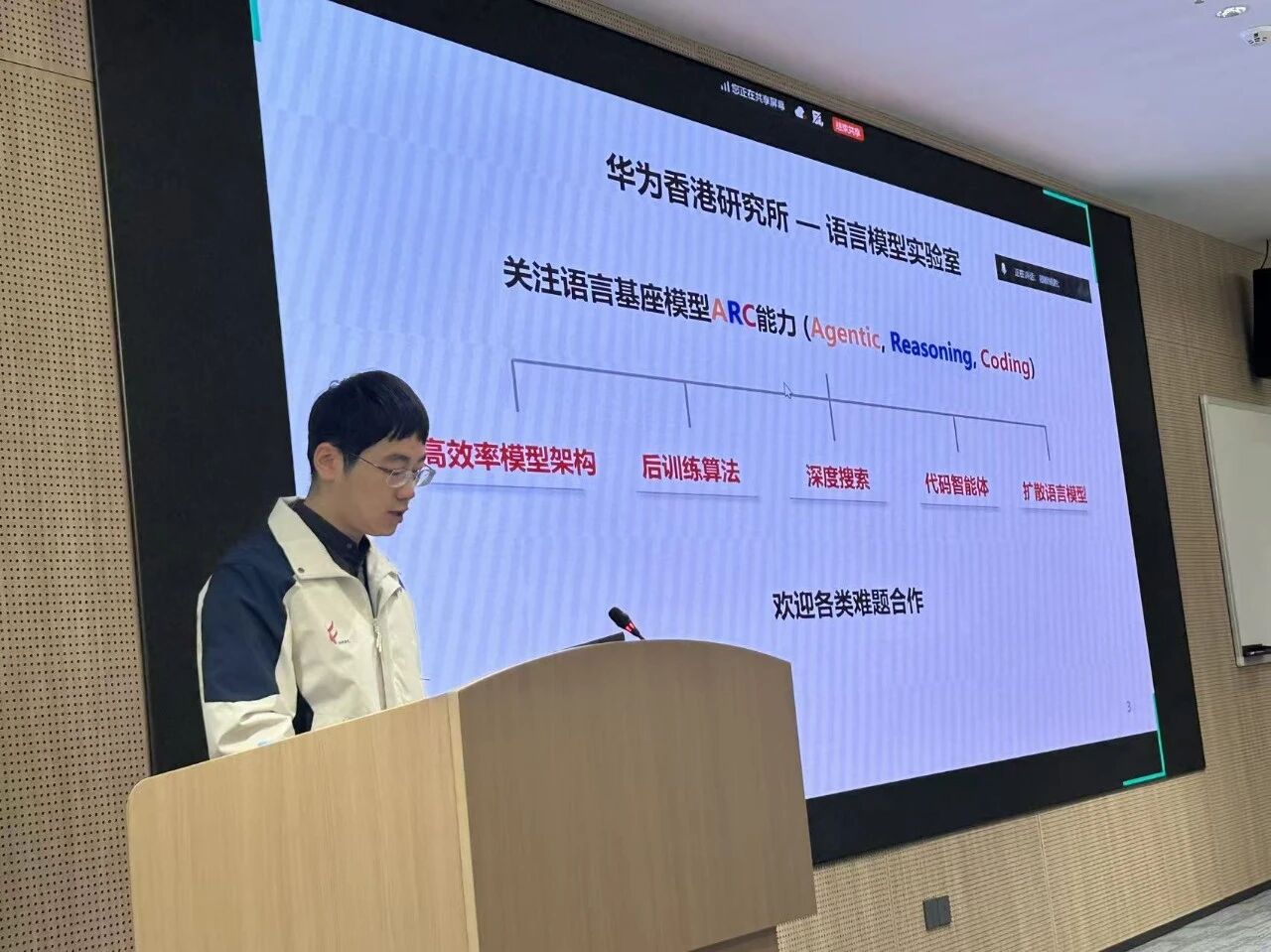

在大模型参数规模与上下文窗口激增的背景下,推理成本已成为制约其工业级应用的核心瓶颈。华为香港研究所柏昊立博士以“参数分布”为切入点,深入剖析了大模型在内存墙限制下的计算效率难题,并分享了团队在模型量化与稀疏化领域的系统性突破。

讲座首先聚焦于量化技术的核心挑战——激活值中的“异常值”。柏博士指出,大模型参数分布并非均匀,既存在沿特定通道固定的“常驻异常值”,也包含聚集在句首等特定位置的“极大异常值”。针对前者,柏博士介绍了团队提出的FlatQuant算法。不同于传统的逐通道缩放,FlatQuant利用可学习的仿射变换矩阵,对权重和激活值进行“平坦化”映射,在数学层面消除了分布的陡峭性,从而实现了高精度的4-bit无损量化。针对后者,团队提出了IntactKV策略,即保留系统前缀等关键位置的高精度键值缓存(KV Cache),仅对用户输入部分进行量化,这种“关键分离”策略有效规避了极大离群值对整体精度的破坏。

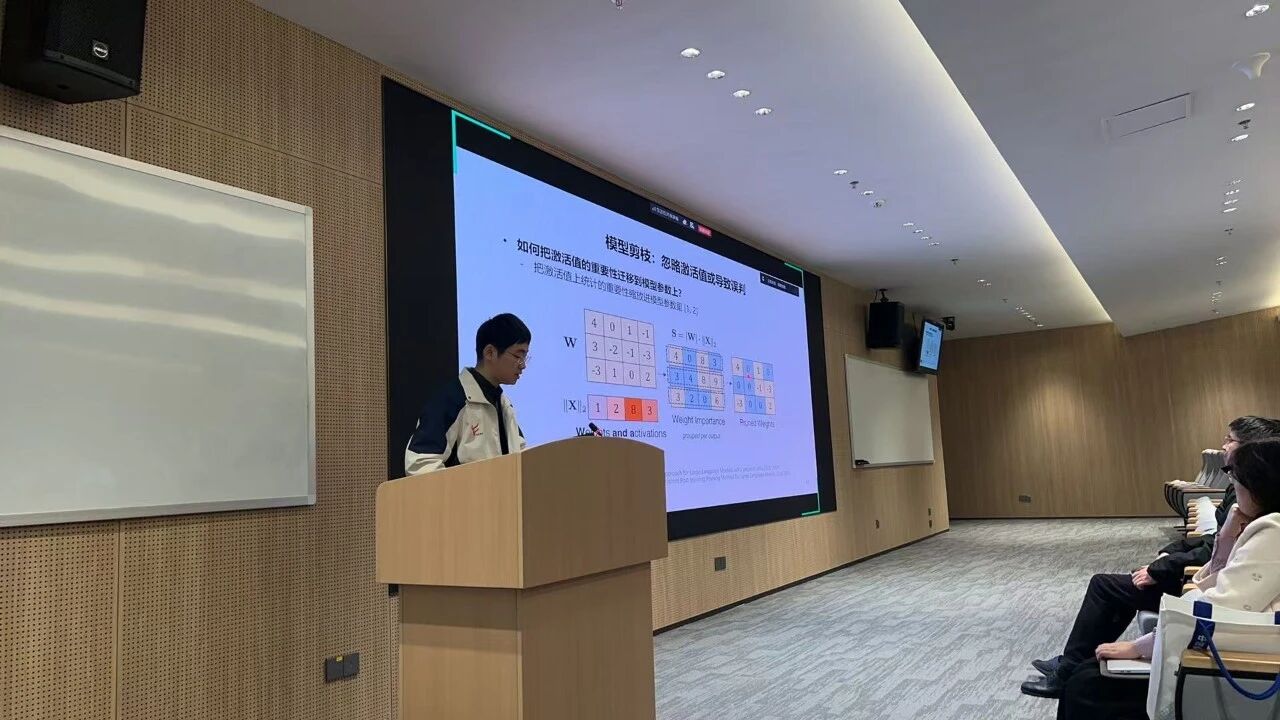

在稀疏化研究方面,柏博士探讨了突破半结构化剪枝精度上限的路径。针对重要参数因受限于固定通道分布而被错误剪除的痛点,团队创新性地引入了通道重排序机制,通过全局重排将重要参数聚合保留,在保证计算效率的同时显著提升了模型精度。此外,针对层剪枝导致的层间特征幅值错位问题,他提出了利用轻量级线性补丁进行特征对齐的方案,以极小的计算代价修复了剪枝后的模型性能。

最后,柏博士展望了“慢思考”时代的压缩新机遇。他指出,随着思维链长度的增加,量化误差在复杂推理任务中极易累积,这对未来的压缩算法提出了更高要求。同时,他也探讨了量化技术在强化学习中的应用,特别是如何解决训练与推理精度不一致导致的策略偏离问题。

在交流环节,与会师生就量化感知训练的数据集偏差、存量芯片的低比特支持以及长文本智能体的显存优化等前沿议题与柏博士进行了深入探讨。